https://japan.zdnet.com/article/35215769/

日本IBM、独自LLM「Granite日本語版」を提供--日本語の長文を効率的に処理

日本IBMは2月27日、日本語性能を向上させたAI基盤モデル「Granite(グラナイト)日本語版モデル」の提供開始を発表した。ビジネスに特化したAI&データプラットフォーム「IBM watsonx」で使用する。

日本IBM 理事 テクノロジー事業本部 watsonx事業部長の竹田千恵氏は、「モデルライブラリーから日本語特化の大規模言語モデル(LLM)など複数のモデルを選択できるが、顧客のビジネスニーズを担保するチームとして、50カ国以上で600人以上のAIエンジニアを無償で提供している」とAI戦略に注力する姿勢を強調した。

日本IBM 理事 テクノロジー事業本部 watsonx事業部長 竹田千恵氏

現在のwatsonxは、AI活用や構築に用いる「watsonx.ai」、自社のデータを一元管理して活用する「watsonx.data」、データとAIのガバナンスを保全する「watsonx.governance」の3つが主軸となる。今回発表したGranite日本語版モデルはwatsonx.aiで使用する日本語用のLLMだ。

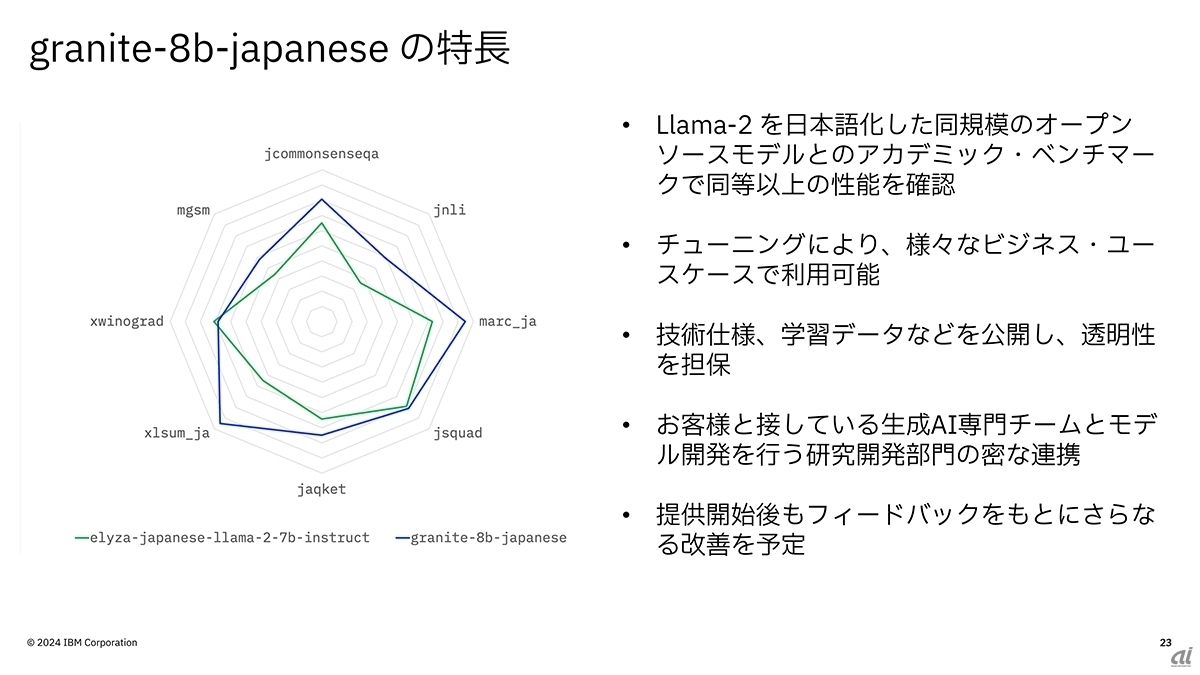

watsonx.aiは基盤モデルライブラリーとして、複数のモデルを使用できる。直近だけでも2023年11月にはMetaの「llama2-13b」、2024年1月にはELYZAが日本語版LLMとして公開した「elyza-japanese-llama-2-7b」、同年2月にはオープンソースの「mixtral-8x7B」を追加。そして今回Granite日本語版モデルとなる「granite-8b-japanese」が加わった。

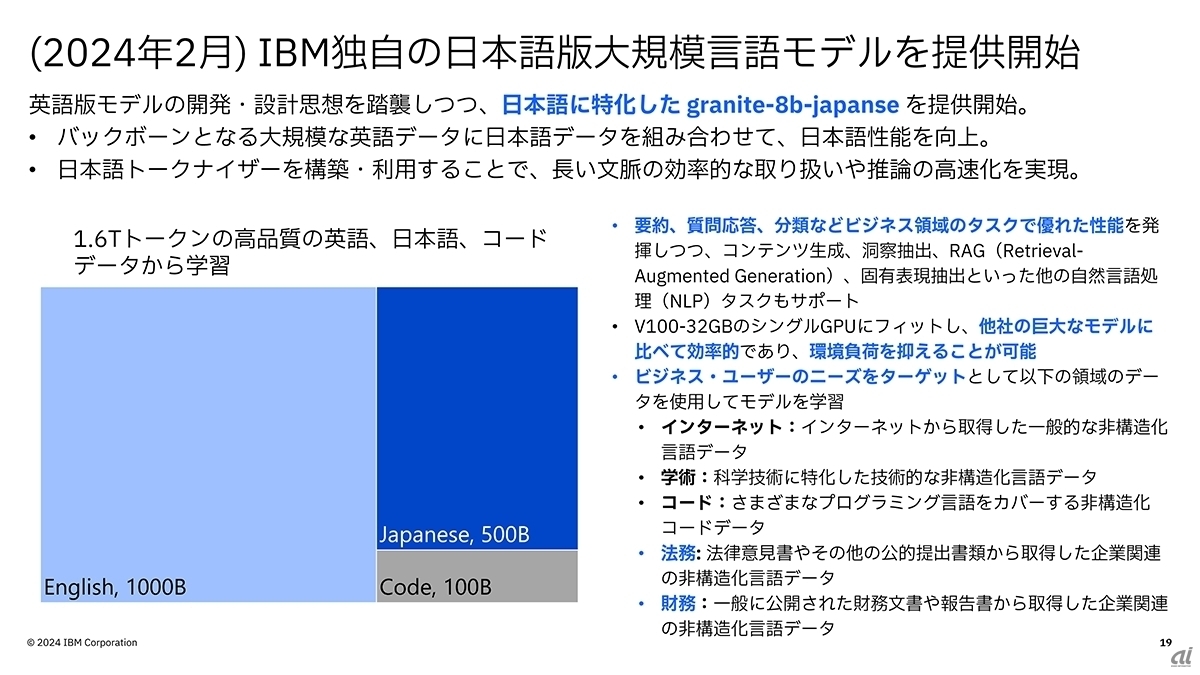

IBM独自のLLMとなるGraniteは2023年9月に提供を開始しているが、Granite日本語版モデルは1.6T(1.6兆)の学習データを用意し、英語1000B(1兆)トークン、日本語500B(5000億)トークン、プログラミングコードで100B(1000億)の大型モデルとなる。Graniteと同じくコンテンツ生成や洞察抽出、 固有表現抽出、生成精度を高めるRAG(検索拡張生成)で業務支援を行い、「NVIDIA V100-32GB」でも動作するため、「IBM Cloud」だけでなくオンプレミスでも利用環境を構築できる。

Granite日本語版モデルの特徴

当然ながら基となる学習データは前処理が欠かせない。日本IBM 技術理事 東京基礎研究所AI Technologies担当シニア・マネージャーの倉田岳人氏は、13.9TBにおよぶ日本語学習データに対して「データのフィルタリングが必要。重複内容やHAP(Hate, Abuse, Profanity)、暴力的な表現などビジネス観点でふさわしくない文章の除去を行う。加えて多様な角度から文章品質を計算して不要なデータを取り除くと1.3TB」まで圧縮している。

もう一つの特徴が日本語トークナイザーだ。文章を単語や慣用句に分割する処理だが、同社によれば日本語未対応のトークナイザーで処理すると、日本語の文字は語彙に含まれない場合があり、バイト単位に分割されてしまう。だが、同社が開発した日本語対応のトークナイザーであれば単語を1トークンとして扱うため、推論速度を犠牲にせず、扱える文脈も広まるという。

日本IBM 技術理事 東京基礎研究所AI Technologies担当シニア・マネージャー 倉田岳人氏

日本IBMが行ったベンチマークでも、Granite日本語版モデルは、日本語対応のelyza-japanese-llama-2-7bと同等以上の性能を達成し、多様なビジネスシーンでの利用が期待できるとしている。倉田氏は「技術仕様、学習データなどを公開して透明性を担保していく。また、テクノロジー事業本部やコンサルティング部門、顧客担当チームが連携して、Granite日本語版モデルの有効活用を支援する」と述べた。さらに竹田氏は、「日本語に特化したモデルは大きな強み。今後3年間の生成AIがもたらす影響を鑑みれば、右肩上がりの事業成長を予測している」という。

現在、同社は前述したwatsonxプラットフォームと人材育成ソリューションの「watsonx Orchestrate」、対話型AIの「watsonx Assistant」、生成AIがコードを生成する「watsonx Code Assistant」に代用されるAIアシスタント群を、ITオートメーションやセキュリティ、モダナイゼーション、サステナビリティーに類する製品群へ組み込んでいくとしている。

Granite日本語版モデルのベンチマーク結果

ZDNET Japan 記事を毎朝メールでまとめ読み(登録無料)

0 件のコメント:

コメントを投稿