https://gigazine.net/news/20240314-cerebras-wse-3-world-fastest-ai-chip/

https://gigazine.net/news/20240314-cerebras-wse-3-world-fastest-ai-chip/

AI向けコンピューターシステムを構築するスタートアップのが、4兆個のトランジスタを搭載した世界最速のAIチップ「(Third Generation 5nm Wafer Scale Engine:第3世代5nmウェハスケールエンジン)」を発表しました。この他、AI運用におけるボトルネックとなるコストパフォーマンスを改善するために、QualcommのAI 100 Ultraを利用することや、G42と共同で新しいAIスーパーコンピューターの「」を構築することなども発表されています。

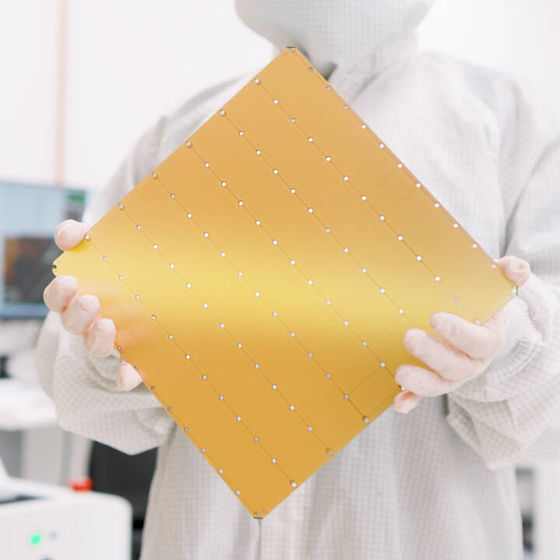

現地時間の2024年3月13日、生成AI向けのコンポーネントを開発するCerebrasが、「WSE-3」を発表しました。これにより、既存のAIチップで最速のパフォーマンスを実現していた「WSE-2」と比べてパフォーマンスは2倍に向上しながら、消費電力および販売価格は同じままを維持することに成功しています。

WSE-3の主な仕様は以下の通り。

4兆個

90万個

125PFLOPS(ペタフロップス)

44GB

21PB

214Pbit

TSMC 5nm

1.5TB、12TB、1.2PB

最大24兆のパラメーターまで

最大2048のシステム(WSE-3を搭載したコンピューティングシステム)

なお、WSE-3は一辺が21.5cmの正方形となっており、世界最大の単一チップとも呼ばれています。

最大1.2PBのメモリシステムを備えたCS-3は、GPT-4やGeminiの10倍の次世代フロンティアモデルをトレーニングできるように設計されています。24兆のパラメーターモデルは、パーティショニングやリファクタリングを行わずに単一の論理メモリ空間に保存できるため、トレーニングワークフローが大幅に簡素化され、開発者の生産性が向上します。

そのため、CS-3で1兆のパラメーターモデルをトレーニングすることは、GPUで10億のパラメーターモデルをトレーニングするのと同じくらい簡単になるそうです。また、フルスケールのCS-3なら、Metaの大規模言語モデルであり700億ものパラメーターを持つLlama 70Bを、「1日でゼロからトレーニングできる」とアピールされています。

Cerebrasによると、AI導入における本当の限界は、推論とニューラルネットワークモデルの実行にあるそうです。Cerebrasの試算によると、地球上のすべての人がOpenAIのChatGPTを利用した場合、年間1兆ドル(約150兆円)もの費用がかかり、エネルギーの消費量もとてつもなく膨大なものとなってしまう模様。

そこで、CerebrasはAI推論で前例のないパフォーマンスを実現するために、Qualcommのを使用することを発表しました。これにより、推論コストを最大10分の1に下げることが可能となるそうです。

Cerebras共同創設者でありCEOでもあるアンドリュー・フェルドマン氏は、「この取り組みは、高性能かつ低コストのAI推論の新時代の到来をもたらすことを目的としており、これ以上ないタイミングです。当社の顧客は、推論時に大金を支払わない最高品質の最先端モデルをトレーニングすることに重点を置いています」「QualcommのAI 100 Ultraを利用することで、モデルの品質を犠牲にすることなく推論コストを大幅に削減でき、現在利用できる最も効率的な導入につながります」と語りました。

この他、Cerebrasは大手技術保有グループのG42と共同で、AIスーパーコンピューターの「Condor Galaxy 3(CG-3)」を構築する計画を発表しました。CG-3は業界最速のAIチップであるWSE-3を搭載したCS-3が64台搭載されており、これによりAIに最適化されたコア数が5800万個を超え、処理速度は8EFLOPS(エクサフロップス)に至ります。

CerebrasとG42はこれまでにAIスーパーコンピューターのCondor Galaxy 1とCondor Galaxy 2を共同で開発しているため、CG-3は両社のパートナーシップによる3つ目のAIスーパーコンピューターとなります。これらの3つのAIスーパーコンピューターにより、Condor Galaxyネットワーク全体の処理速度は合計16EFLOPSに到達する模様。

なお、CerebrasとG42が開発するAIスーパーコンピューターのCondor Galaxyは、これまでJais-30B、Med42、Crystal-Coder-7B、BTLM-3B-8Kなど、業界をリードする最先端の生成AIモデルのトレーニングに利用されてきました。

Condor Galaxy 3は2024年第2四半期にリリースされる予定です。

0 件のコメント:

コメントを投稿