https://gigazine.net/news/20240807-ai-energy-consumpiton-by-up-to-2500-times/

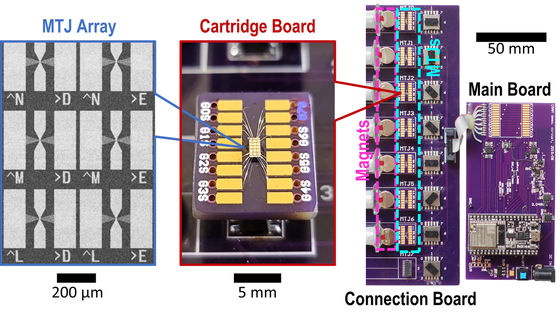

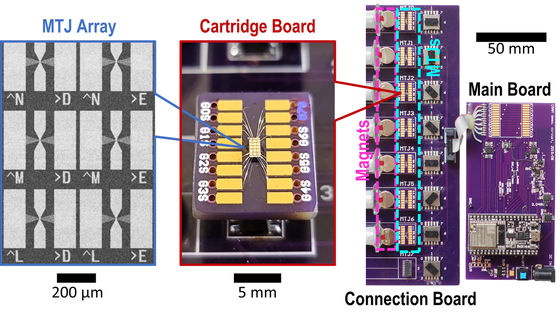

メモリセル内で直接計算を行うことにより、データ転送の発生を抑えて、コストを抑えながら高いパフォーマンスを実現するハードウェアデバイスを、ミネソタ大学ツインシティーズの研究者が実証しました。これにより、AIのエネルギー消費量を最大で2500分の1に削減することができます。

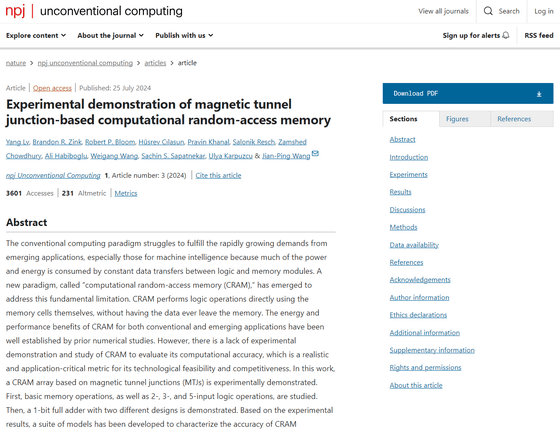

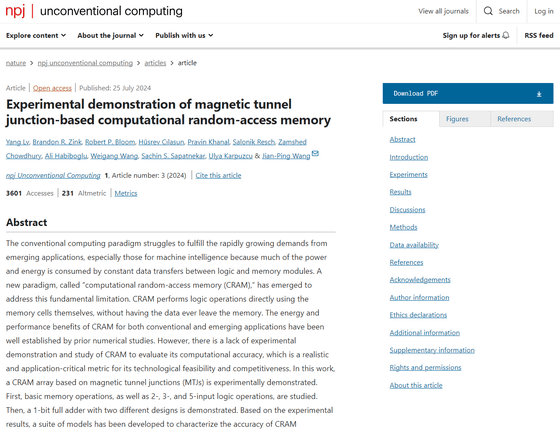

Experimental demonstration of magnetic tunnel junction-based computational random-access memory | npj Unconventional Computing

https://www.nature.com/articles/s44335-024-00003-3

Researchers develop state-of-the-art device to mak | Newswise

https://d.newswise.com/articles/view/814628/

'Crazy idea' memory device could slash AI energy consumption by up to 2,500 times | Live Science

https://www.livescience.com/technology/computing/crazy-idea-memory-device-could-slash-ai-energy-consumption-by-up-to-2-500-times

一般的な「コンピューティング」では、データは、データを処理するためのプロセッサと、データを格納するメモリの間を常に移動することになります。AIコンピューティングの場合、計算が複雑で大量のデータをやりとりすることになるので、特にエネルギーの消費量が多くなります。

国際エネルギー機関(IEA)の年次レポートによると、AIを含むデータセンターのエネルギー消費量は2022年時点では460TWhでしたが、2026年には1000TWhへと倍増する見込みです。この値は、日本の総消費電力に匹敵します。

0 件のコメント:

コメントを投稿