皆さん、GPUという言葉は耳にしたことがありますか?GPUとは、Graphics Processing Unitの略で、元々はゲームやテレビの用途でコンピューターのグラフィックス処理を担当するために開発され、現在はAI開発の用途でも大いに活用されています。 実は、このGPUが、あと3〜4年後に始まると予想されている量子コンピューターの実用化に、大きく寄与しているのです。

今回は、GPUと量子コンピューターの意外な関係を明らかにします。GPUや量子コンピューターについてあまり知らない人も、ぜひ読んでみてください!

量子コンピューターの実用化は意外と早い

量子コンピューターについては、最近、見聞きする機会が増えてきました。スーパーコンピューターを上回る、未来の超高速コンピューターとして期待されています。しかし、結局いつ実用化されるのか?と疑問に思っている人も多いでしょう。

何と現在、実用化は意外と早いだろうという予測がされています。下記の記事によると、今から約4年後の2027年前後に、「Early-FTQC」時代というエラー耐性を実装した、初期段階の量子コンピューター活用が始まると考えられています。つまり、量子コンピューターが現実のものとなるのは、そう遠い未来の話ではないのです!

[nlink url=https://www.leapleaper.jp/2023/07/13/when-will-the-era-of-quantum-computers-arrive/]

実用化まではGPUを用いた量子コンピューターのシミュレーションが最重要

でも、「Early-FTQC」時代の実現までの間、研究者らは何をして待てばいいのでしょうか?実は、この時期は量子コンピューターの研究開発にとって非常に重要なフェーズなのです。というのも、量子コンピューターアプリケーションの性能を古典コンピューター(現行のコンピューター)でシミュレーションしたり、どのような量子優位性が得られるかを検証する必要があるからです。そして、このシミュレーションには、AI開発でお馴染みの「GPU」が大いに活躍しているのです!

量子コンピューターの正体は、ベクトル-行列の演算を処理する計算機

量子コンピューターは、本質的には「ベクトルと行列の演算を処理する計算機」といえます。その理由は、量子コンピューターの基本的な演算ユニットである「量子ビット」や「量子ゲート」が、線形代数の概念であるベクトルと行列を用いて表現されるためです。

量子ビットと量子ゲートを組み合わせて形成される「量子回路」は、その本質においては、ベクトルに対する行列の作用という形をとります。つまり、量子コンピューターの演算とは、一連の行列の演算によってベクトルが変換される過程をシミュレートしたものといえるのです。量子回路については、以下の記事で説明しているので、ぜひチェックしてみてください!

[nlink url=https://www.leapleaper.jp/2023/06/07/nisq-as-incomplete-quantum-computer/]

シンプルかつ大量の行列計算が得意な「現代の宝石」GPUメモリ

皆さんは最近、NVIDIA(エヌビディア)という企業の株が急騰し、同社が世界最高峰の時価総額企業となったニュースを見たことはありませんか?

背景としては、そのNVIDIAが開発した「GPU」が、ChatGPTに代表される生成AI開発において必須の代物であり、需要が非常に高まっていることが挙げられます。このようなAI開発は、大量のデータを高速に処理する必要がありますが、そのためにはGPUの力が欠かせません。また、量子コンピューターの研究開発においても、同様に大量の計算を高速に行うことが求められるため、GPUが活躍しているのです。

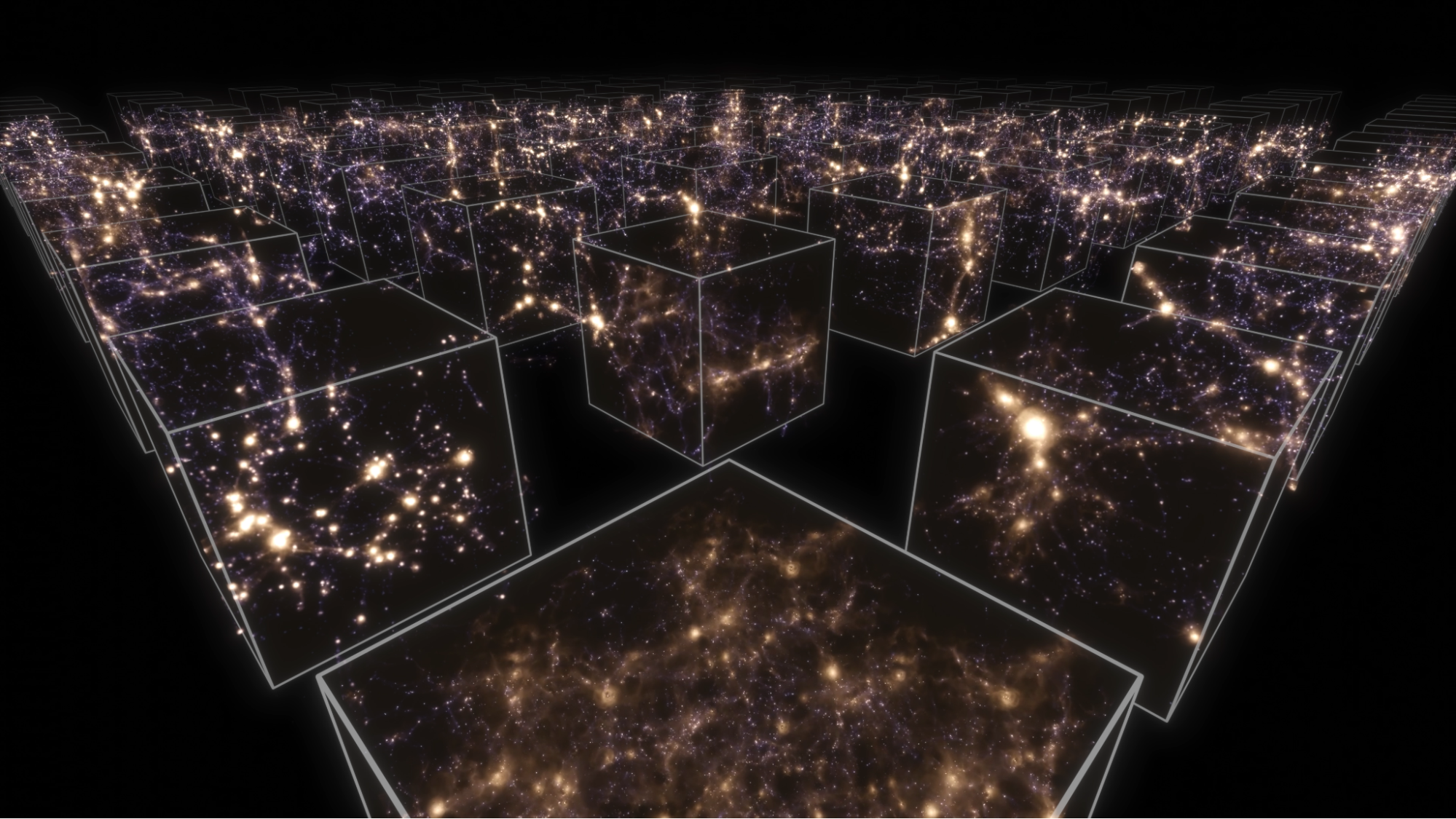

出典:cuQuantum SDK | NVIDIA

https://developer.nvidia.com/cuquantum-sdk

GPUが得意とする計算の種類は、行列計算やグラフィックスのような「シンプルかつ大量かつ高速」な計算です。このGPUの特性が、AI開発における大量のデータ処理と非常にマッチしているのです。生成AI開発ではモデルの学習のために、巨大なサイズのベクトルと行列を大量に計算することが求められるため、莫大な投資に基づくより高性能なGPUの奪い合いが世界中で起きているのです。

GPUは、2027年前後での量子コンピューター実用化までの「繋ぎの技術」となる!

なぜ、量子コンピューターのシミュレーションにGPUが有効なのでしょうか。それは、先ほど説明した量子計算の仕組み上、量子コンピューターのシミュレーションにおいても、AI開発と同様に、巨大なベクトルと行列の計算を大量に処理する必要があるからです。

量子ビットの特性上、量子ビットの数が増えると、それを古典コンピューターでシミュレートするための、ベクトルや行列のサイズは指数関数的に大きくなります。そのため、量子ビット数をある程度増やした状態で量子コンピューターをシミュレートするためには、大規模な行列計算の得意なGPUの力が必要となるのです。

「GPUとAI」の関連性はある程度認知されてきていますが、このように意外と「量子コンピューターとGPU」の間にも大きな関連性があるのです。実際、NVIDIAは昨年、GPU開発の他、量子コンピューターシミュレーションの分野でも世界最速の成果を発表しています。

意外と早い量子コンピューターの実現で、結局何が起こる?

『シミュレートできるなら、本物の量子コンピューター要らないじゃん』そう思った方もいるのではないでしょうか。

それは違います!シミュレーションと実機で大きく違うのは、計算に必要なリソース、特にメモリの量です。量子ビット数が増えると、それをシミュレートするためのGPUメモリ要求量は、量子ビット数に対して指数的に増えてしまいます。つまり、量子ビット数が増えるほど、シミュレーションに必要なメモリリソースが急激に増大するのです。

しかし、量子コンピューター自体はこのような制限を受けません。なぜなら、量子コンピューターは、自然の摂理に伴って状態を変換するからです。つまり、量子コンピューターは大量のメモリを消費して真面目に数値計算するシミュレーションとは異なり、メモリ消費を大幅に抑えて計算することができるのです。この圧倒的な差こそが、量子コンピューターを開発する大きなモチベーションとなっています。

そして筆者の予想では、2027年前後に実現が予想される「Early-FTQC」時代では、小規模な量子コンピューター実機とGPUのハイブリッドに基づく「量子古典ハイブリッドスパコン」なる、スーパーコンピューターが活躍する時代になると考えられます。つまり、現在のAIスパコン同様、計算の大部分を超高性能GPUが担う傍ら、古典コンピューターでは苦手でかつ量子コンピューターなら得意な問題領域に関しては、Early-FTQC実機がGPUを凌駕するパフォーマンスで計算する仕組みです。

すでに、このハイブリッドスパコンの概念はNVIDIAなどによって提唱されていて、本格的な社会実装はそう遠くないと筆者は考えています。

ChatGPTだけじゃなく、量子コンピューターにも重要なGPU

今回は、GPUと量子コンピューターの間に大きな関係があることを見てきました。GPUは、大量の計算を高速に処理できるため、量子コンピューターのシミュレーションに大いに役立っています。そして、このシミュレーションを通じて、量子コンピューターアプリケーションである機械学習や材料計算に活発に使われています。

興味深いニュースでした。まだまだ新しい技術が生み出されていることが分かり、面白かったです。

お読みいただきありがとうございました。NVIDIA株、買っとくんだった!とか、そういうことより大事なことってあるんですね 😛