https://news.mynavi.jp/techplus/article/svalley-984/

https://news.mynavi.jp/techplus/article/svalley-984/

CES 2024(1月7〜10日)で発表された数多くのAI製品の中で、特に注目を集めたAIパーソナルガジェット「Rabbit r1」。大規模アクションモデルを搭載しており、学習したアプリのインターフェイスや利用方法を柔軟に再現する。AIエージェントを活用したアプリ利用を提案している。→過去の「シリコンバレー101」の回はこちらを参照。

RabbitのパーソナルAIデバイス「r1」

昨年は主にクラウドに依存していた生成AIが、今年はAI PCやAI Phoneなどの登場によりオンデバイスに移っていく見通しである。オンデバイス処理により、個人情報、財務情報、医療情報といったセンシティブな情報でもデバイス内で安全に管理できるため、生成AIの活用範囲が拡がる。

また、位置情報やデバイス利用から得られるユーザーの好みや行動のデータを基に、よりパーソナライズされたAIアシスタントも可能となる。データセンターの負荷とエネルギー消費という社会的問題に対しても、デバイスへの分散により削減が期待できる。

AIデバイスには2つのアプローチがある。1つは、既存のPCやスマートフォンのAI処理性能を向上させ、生成AI機能を導入するもので、Windows 10/11のCopilotが代表例である。

もう1つは、AI時代のコンピューティングを思い描いて一から設計したデバイスで、こちらもHumaneのウェアラブルデバイス「Ai Pin」などいくつかの製品が登場しており、米ラスベガスで開催されていたCES 2024でもAIを利用した数多くの製品が発表された。今年は新興企業の参加も活発で、中でも話題を集めたのが元Googleのエンジニアによって設立されたRabbitのパーソナルAIデバイス「r1」である。

r1は78x78x13ミリ、重さは115グラム。2.88インチのタッチスクリーン・ディスプレイを搭載。通信機能は、Bluetooth 5.0、Wi-Fi(2.4GHz+5GHz)、4G LTEなど。価格は199USドル、利用にサブスクリプションは不要

LAMを導入したr1の機能

r1は、ポスト・イットの束ほどの大きさのAIデバイスで、ハードウェアデザインはスウェーデンのteenage engineeringが担当している。Large Action Model(LAM:大規模アクションモデル)と呼ぶ独自のAIモデルを採用しており、AIがユーザーに代わってアクションを実行する。例えば、以下のようなやり取りでUberの配車を手配できる(Rabbit r1発表会のデモから)。

- ユーザー「オフィスから自宅まで車を手配してください」

- r1「わかりました、オフィスから自宅までUberを手配します」

- r1「(予約画面を表示して)確認してください」

- ユーザー「6人と大きな荷物3つに十分なUberを見つけてください」

- r1「6人と荷物3つならUber XLの予約をおすすめします」

- r1「(予約画面を表示して)確認してください」

- ユーザー「(確認ボタンをタップ)」

ユーザーは、アプリを開いたり、アプリで目的地や条件を入力することなく、ボタンを押して話す(Push-to-Talk)だけで簡単にUberのアレンジを完了できる。

Rabbitは音声プロンプトの処理とアクションを高速に実行できるように「rabbit OS」という専用のOSを用意しており、ユーザーの質問に対してr1は500ミリ秒以内に回答を返す。これは「ほとんどの音声AIプロジェクトよりも10倍高速である」という。

実際、デモを見る限り、ChatGPTのモバイルアプリと比べてレスポンスが非常に高速で、金融情報の検索やWikipediaに載っているような情報を問うような質問なら、テンポのよい会話を実現していた。

RabbitのLAMは、さまざまなアプリを使った何千ものユーザーセッションの動画で訓練されている。アプリのユーザーインターフェイス、人がアプリを使用するステップや方法、タスク遂行方法、アプリが提供するサービスなどを学習しており、ChatGPTなどと同じようにユーザーの自然言語による音声プロンプトを理解し、その上で、タスクを達成するためのアプリ操作を選択して実行する。複数のアプリやサービスを連携したフローにも対応する。

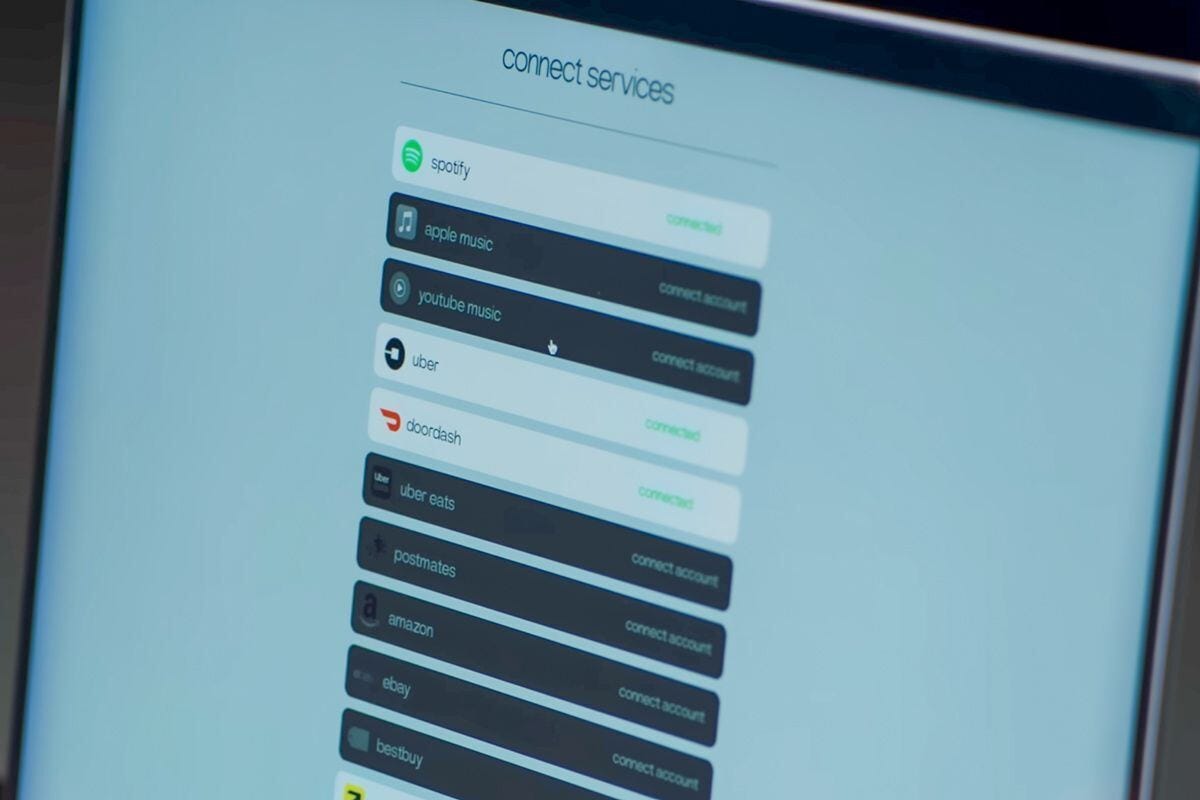

ユーザーはPCで「Rabbit hole」という設定ポータルにアクセスして、自分が使用しているアプリやサービスを登録する。Spotifyのようなログインが必要なサービスでも、Rabbit holeを通じてサービスにログインしてアクセスの許可を得ることでr1での利用が可能になる。

今年後半にはユーザーが任意のアプリやサービスの利用をLAMに学習させる機能も追加

r1のように人のアプリ利用をAIが再現しなくても、API連携によってアプリやWebサイトをつないだフローは可能である。しかし、APIを通じて利用できる機能は限られていることが多く、そして多くのアプリメーカーはAPIの機能セットを増やすことに消極的であるとRabbit CEO、ジェシー・リュー氏は指摘している。

現時点でr1は、RabbitのAIモデルが学習したアプリやサービスにしか対応できないが、今年の後半には「teachモード」が追加される。ユーザーが任意のアプリやサービスの利用をLAMに学習させる機能だ。

製品発表会のデモを紹介すると、PCでteachモードのセッションを開始し、Midjourneyでイヌの画像を生成する様子を録画して、そのビデオをRabbitにアップロードして学習させた。完了後に、r1で「ピクセルアート・スタイルでうさぎの画像を作って」と頼むだけで、Midjourneyを使って生成したうさぎの画像を得ることができた。

Rabbitが学習させたアプリやサービスでしか利用できないお仕着せのAIデバイスだったら、r1を利用できる範囲は限られる。しかし、teachモードによりユーザーは柔軟かつ能動的にr1をカスタマイズできるようになる。それによってAIエージェントの有用性が大きく向上する。

私はキーノートを見終わった後にr1を予約した。r1はスマートフォンの置き換えになるようなデバイスではない。スマートフォンと比べると、できることは限られている。スマートフォンでLAMが機能するように提供する方法もあったと思うが、Rabbitは専用端末としてリリースすることを選んだ。つまり、同社はユーザーが自分のアプリを使うためにAIエージェントを利用することを提案しているのだ。

AIエージェントにアプリを操作してもらってタスクを完了させる体験がどのようなものになるかはわからない。スマートスピーカーの時のように、最初は面白くてもだんだん使わなくなってスマートフォンに戻ってしまうかもしれない。

しかし、「画面をタップするより、Push-to-Talkで使った方が効率的」とr1に手が伸びるようになるなら、それはポストスマートフォンの体験の可能性を示す。付け加えると、このエージェントは広告を見たり、アプリ内購入をするよう説得されることはない。

他にもAIエージェントをはさむことで解決できそうなネットの問題はいくつもあり、r1をきっかけに、SiriやGoogleアシスタントのようなスマートフォンOS標準のアシスタントにもAIエージェントが採用されることになれば、モバイルコンピューティングの新たな展開になる可能性がある。

そんな期待を抱きつつ、実際にr1を手に入れたら、r1が対応できるサービスの多様性、音声プロンプトに対するアクションの精度、マルチアプリ・アクションやワークフローの有用性など注意深く見ていこうと思う。

0 コメント:

コメントを投稿