https://gigazine.net/news/20240307-nvidia-ai-gpu/

AIの研究開発が急激に進む中、「AI用GPU」を開発するNVIDIAにも大きな注目が集まっています。しかし、「AIの研究開発や運用にGPUが使われている」ということは知っていても、どんなGPUがどんな規模で使われているのかはイメージしにくいものです。そこで、NVIDIAのAI特化GPUやプラットフォームについてまとめてみました。

AIサービスを提供するには、必要なデータを収集してモデルデータを構築する「学習」と、モデルデータにプロンプトを入力して出力を生成する「推論」という2種類の計算処理を実行する必要があります。例えば、画像生成AIの場合は「大量の画像や画像の説明をもとにモデルデータを構築する計算処理」が学習で、「モデルデータを使って画像を生成する計算処理」が推論です。この学習や推論では膨大な計算処理を並列実行する必要があるため、CPUよりもコア数の多いGPUの方が効率的に計算を実行できます。

小規模なモデルデータの学習や推論ならゲーマー向けに出荷されているGPUでも実行可能ですが、ゲーム向けGPUはあくまでゲーム関連の処理に最適化されているため、最大効率を発揮することはできません。そこで、NVIDIAは「」や、「」といったAIの学習および推論に最適化したアーキテクチャを開発し、Ampereを採用した「」やHopperを採用した「」といったAI特化GPUを製品化しました。

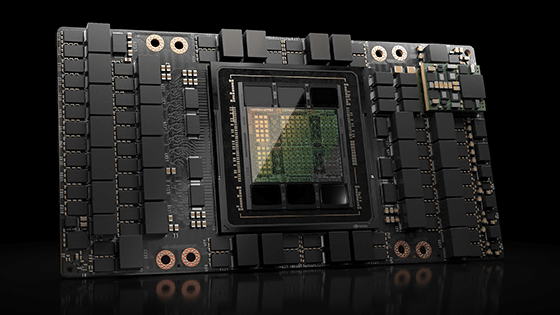

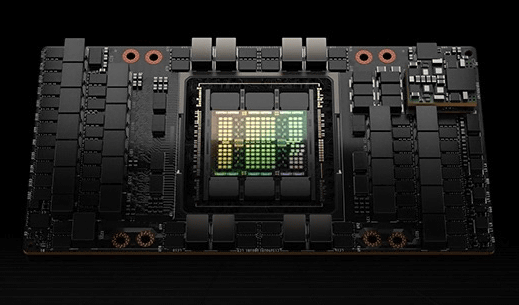

H100の見た目はこんな感じ。NVIDIAはH100の価格を公表していませんが、ニューヨーク・タイムズはH100の価格を1台当たり2万5000ドル(約370万円)としています。H100はあまりにも価値が高いため、輸送には装甲車が使われるとのこと。

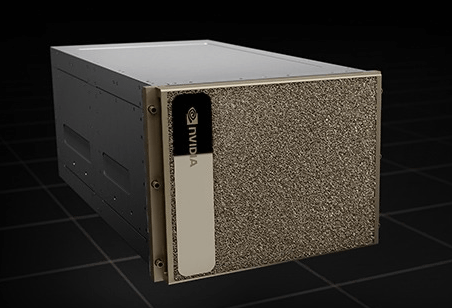

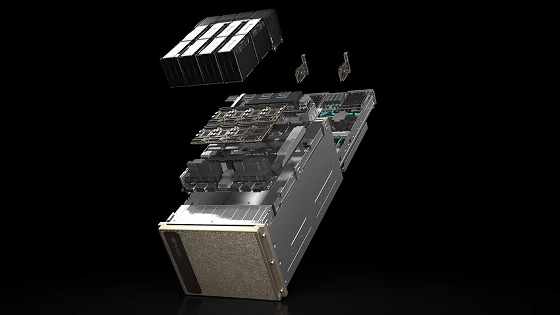

NVIDIAはAI特化GPUだけでなく、AI特化GPUにCPUやメモリ、ストレージなどを組み合わせたAI処理システム「DGX」も開発しています。H100を搭載した「DGX H100」の見た目はこんな感じ。

DGX H100にはH100が8台搭載され、毎秒900GBでデータを転送できるGPUメモリが640GB搭載されています。また、x86 CPUが2台、システムメモリは2TB、ストレージは30TB搭載されています。

さらに、NVIDIAは32個のDGXを組み込んだAIインフラストラクチャ「」も開発しています。記事作成時点ではDGX SuperPODには DGX A100を採用したモデルとDGX H100を採用したモデルの2種が存在。つまり、DGX H100を採用したDGX SuperPODには1台当たり約370万円のH100が256台搭載されているというわけです。

なお、NVIDIAはすでにH100の2倍の推論性能を備えた「H200」を開発しており、2024年中に出荷開始することを発表しています。

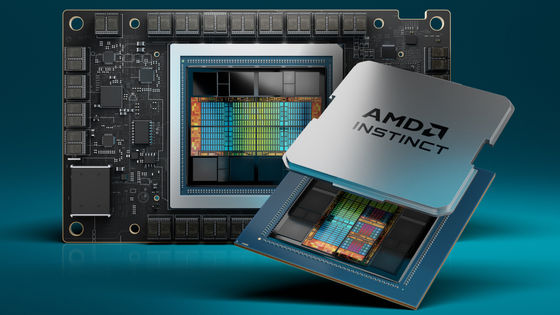

また、NVIDIAのライバルであるAMDもAI特化GPUの開発を進めており、2023年12月にはH100の1.6倍の性能を備えたAI特化GPU「Instinct MI300」を発表しています。

0 コメント:

コメントを投稿