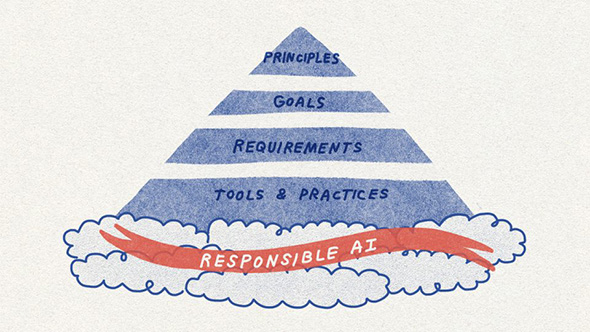

Microsoftは、社会から信頼されるAIの提供に向け、AIの設計、開発、導入の基本指針となる「Responsible AI Standard」を公開した。AIが生活に浸透する一方で法律の整備が遅れ、AI特有のリスクや社会のニーズに追い付いていない今、Microsoftが同ガイドラインで示す6つの必須要件とは。

この記事は会員限定です。会員登録すると全てご覧いただけます。

Microsoftは2022年7月4日、社会から信頼される「責任あるAI」(Responsible AI)システムの開発基準となるフレームワーク「Responsible AI Standard」を公表した。

同フレームワークは、同社の責任あるAI(人工知能)に関する製品/サービスの開発要件を定義したものだ。Microsoftはこれを一般公開することで同社の知見を共有するとともに、AIに関するより良い規範とプラクティス(実践手法)を構築するための議論に貢献するとしている。

「責任あるAI」に求められる要素は

Microsoftは、AIシステムはその開発や展開に関わる人々の意思決定の産物だと認識し、より有益で公平な結果を導くためには、意思決定のためのガイドが必要だとしている。

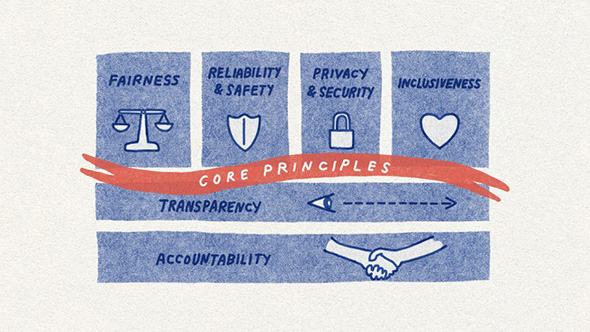

Responsible AI Standardが規定する「責任あるAIシステム」を開発するための必須要件は次の6つだ。

- 「説明責任」(Accountability)

- 「透明性」(Transparency)

- 「公平性」(Fairness)

- 「信頼性と安全性」(Reliability & Safety)

- 「プライバシーとセキュリティ」(Privacy & Security)

- 「包括性目標」(Inclusiveness Goal)

各目標ごとに、AIシステムのライフサイクルを通して達成すべき一連の詳細目標がまとめられており、AI開発者は順を追うことで、押さえるべき要件を把握できる。各目標をまとめた章の末尾には、詳細目標に応じて利用可能なツールとプラクティスも紹介されている。

今回公表されたResponsible AI Standardは、社会から信頼されるAIシステム開発についてMicrosoftの「最善の考え方」を示したもので、従来AIの世界で主流だった概要レベルの原則の紹介にとどまらない、具体的で即実行可能なガイダンスだという。

Microsoftは「AIが生活に浸透する一方で法律の整備は遅れており、AI特有のリスクや社会のニーズに追い付いていないため、このような実践的なガイドラインの必要性が高まっている」と説明する。

「責任あるAI」に向けて製品、サービスに実装されたものは

Responsible AI Standardは、2019年秋にMicrosoftが社内で公開した第1版をベースにした第2版となっている。研究者やエンジニア、政策の専門家などさまざまな分野の識者グループの知見や、これまでのMicrosoftの責任あるAIに関する取り組みと最新研究や製品、サービスから得た教訓などが生かされているという。

第2版は「音声テキスト化技術における公平性」「『Custom Neural Voice』と顔認識技術への適切な使用のコントロール」「目的への適合性とAzureの顔認識機能」といった課題解決に向けた内容だ。

音声テキスト化技術における公平性を確保

AIシステム普及の弊害として、社会の偏見や不平等を悪化させる可能性が懸念されている。2020年3月に発表された学術研究によると、ハイテク分野全般の音声テキスト化技術は、一部の黒人およびアフリカ系アメリカ人ユーザーにおけるエラー率が白人ユーザーの約2倍であることが判明した。

Microsoftはこの理由を、音声テキスト化技術のリリース前のテスト段階でさなざまな背景や地域の人々が使用する言語の多様性を十分に考慮できていなかったことにあると判断し、多様性を深く理解して音声テキスト化技術の性能を向上させるために社会言語学の専門家の協力を得て、データ収集の取り組みを拡大させた。

さまざまな文化背景を持つ言語データを適切かつ敬意を持って収集する取り組みは簡単ではなく、システム性能のばらつきの要因をよりよく理解するためにも早い段階から専門家をプロセスに参加させることが重要だったという。

Responsible AI Standardには、音声テキスト化技術を向上させるために同社がたどった思考や行動様式が反映されている。「同フレームワークに定義された公平性の目標と条件を考慮することで、そうした潜在的な公平性に関わる弊害に先手を打つのに役立つ」と同社は説明している。

Custom Neural Voiceと顔認識技術への適切な使用のコントロール

「Azure AI」が提供するニューラルテキスト読み上げAIサービス「Custom Neural Voice」は、オリジナル音源とほぼ同じ合成音声を作成できる。

多くの顧客がこの技術を活用しており、AT&TはダラスのAT&T Experience Storeで提供する「バッグス・バニー」の店舗体験コンテンツに同技術を利用している。Progressiveは架空の販売員キャラクター「Flo」の声に同技術を導入し、オンライン顧客対応に活用している。

同技術は教育やアクセシビリティー、エンターテインメントなどの分野で活用される可能性がある一方で、不適切ななりすましや聴き手を欺くために使われる可能性もある。

MicrosoftはResponsible AI Standardに定義された「機密性の高い利用」(Sensitive Uses)に関する条件をはじめとする「責任あるAI」の開発プログラムの技術要件を検討し、階層的管理フレームワークを採用した。

具体的には、顧客からのサービスへのアクセスを制限して許容できるユースケースを事前に定義し、「Transparency Note」(透明性に関する注意事項)と「Code of Conduct」(行動規範)に関する条件に照らし合わせてそれを周知徹底することで、合成音声作成時に話者の積極的な関与を可能にする技術的なガイドラインを確立した。このような階層的な管理体制にすることで、「悪用される懸念なく技術を活用できるようにした」と同社は述べる。

Microsoftは、このCustom Neural Voiceでの学びを基に顔認識サービスにも同様の統制を適用する予定だ。これらのサービスの既存顧客への適用を経て、アクセス管理した顧客とパートナーに限定し、ユースケースをあらかじめ定義された許容範囲に絞り込み、サービスに組み込まれた技術的なコントロールを活用するという。

「信頼に足る」AIシステムに必要なものは

Microsoftは、AIシステムが最終的に「信頼に足るもの」になるためには、そのシステムが解決すべき問題に対して適切な解決策を提供できることが必要不可欠だと考えている。

同社はこの考えに沿って、Azureの顔認証サービス「Azure Face Service」をResponsible AI Standardの条件に適合させるため、感情のステータスや性別、年齢、笑顔、顔面の毛、髪型、化粧などアイデンティティー属性を推論する機能を廃止した。

例えば人の顔をスキャンし、表情や動きから感情の状態を推測するような技術には、無制限のAPIアクセスを提供しないこととした。

この背景には、「感情」の定義に関する科学的コンセンサスの欠如や、ユースケース、地域、人口統計を一般化した推測の正当性への疑問、この種の機能に関するプライバシー上の懸念に関する社内外の専門家からの指摘があった。

また、人の感情を推測するAIシステムについては、表情解析などAI技術を用いたものであっても、全てを慎重に分析する必要があると判断したという。

同社は、Responsible AI Standardで定義された「目的に合わせた目標」(Fit for Purpose Goal)と条件は、システムの有効性の事前評価に有効であり、機密性の高い利用(Sensitive Uses)に関するプロセスは、科学的根拠に基づき、影響力が大きいユースケースに対する繊細なガイダンスになるとしている。

「責任あるAI」システムの基本原則をサポートする資料を公開

MicrosoftにおけるAIシステムの設計や開発、導入に関する基準として活用されるResponsible AI Standardには現実世界の課題が反映されている。

さらに詳しく知りたいユーザーのために、「Impact Assessment」(影響評価)に関するテンプレートとガイドや、Transparency Note(透明性に関する注意事項)などの追加資料も公開されている。

Impact Assessment(影響評価)は、AIシステムにおける利害関係者や意図された利益、潜在的な損害などの影響を設計の初期段階で詳細に調査する上で有効であることが、MicrosoftのAI開発チームによって実証されたという。

Transparency Note(透明性に関する注意事項)は、Microsoftの技術における基本構成要素の機能と制限を顧客に開示し、顧客が責任を持って導入を選択するために必要な知識を提供している。

Copyright © ITmedia, Inc. All Rights Reserved.

AIには「信頼」が必要――Microsoft、AIの開発・活用で重視すべき「6つの倫理的要件」を発表

AIには「信頼」が必要――Microsoft、AIの開発・活用で重視すべき「6つの倫理的要件」を発表

0 コメント:

コメントを投稿